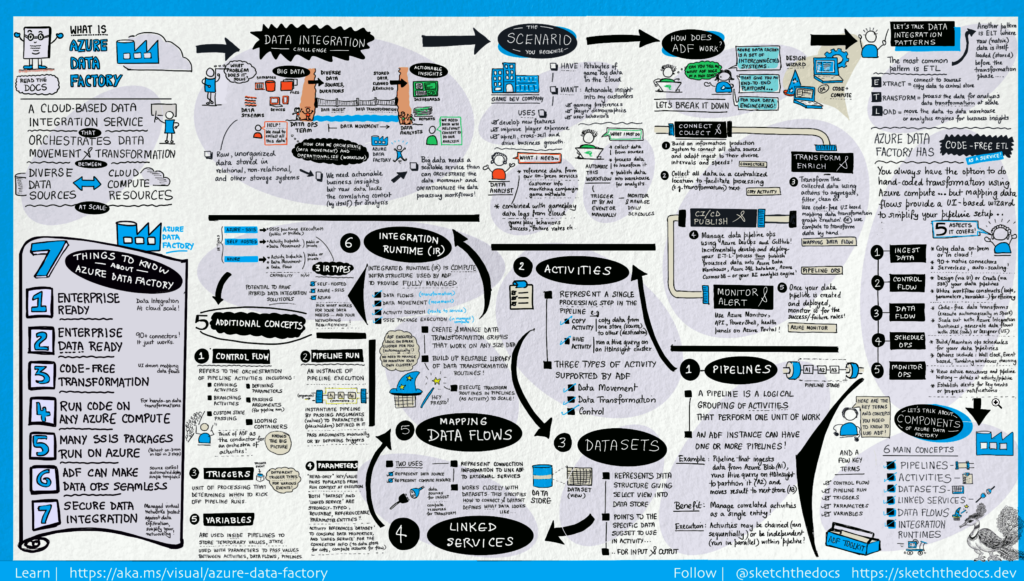

Herstellen einer Verbindung / Sammeln von Daten

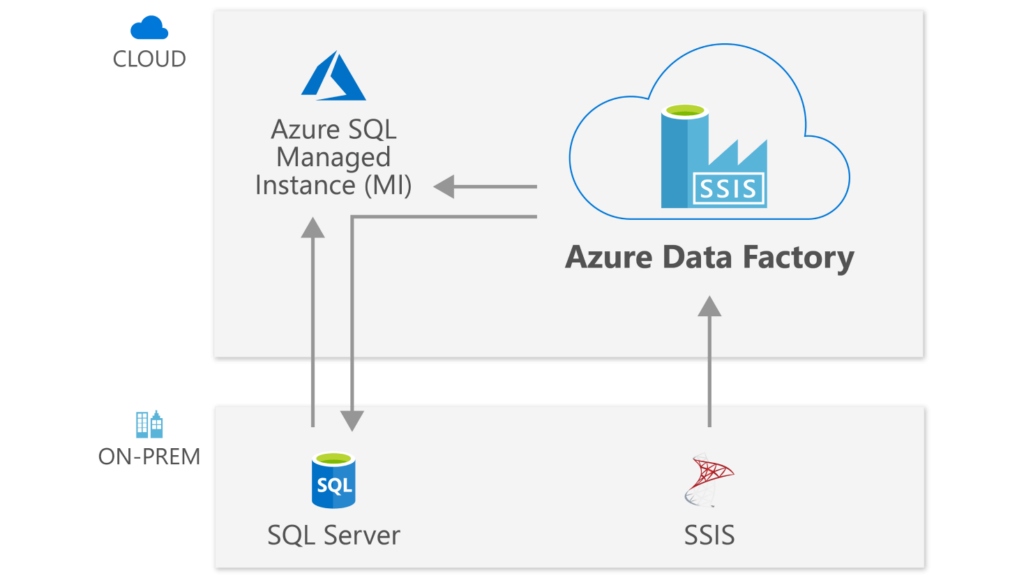

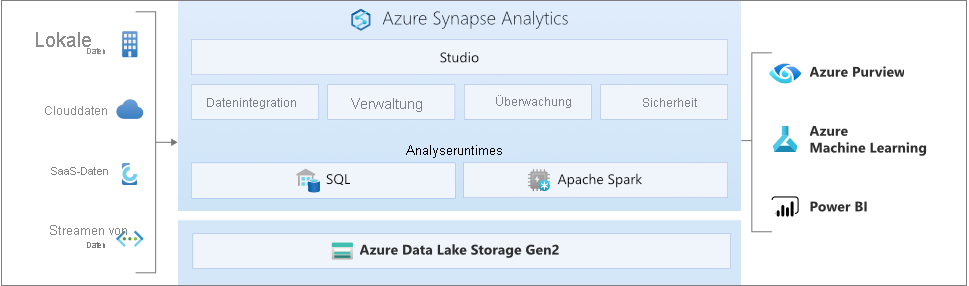

In Unternehmen sind verschiedene Arten von Daten in unterschiedlichen Quellen gespeichert (lokal, in der Cloud, strukturiert, unstrukturiert als auch teilweise strukturiert), meist gehen alle in unterschiedlichen Intervallen, mit unterschiedlicher Geschwindigkeit ein.

Der erste Schritt bei der Erstellung eines Informationssystems für die Produktion umfasst das Herstellen der Verbindung mit allen erforderlichen Daten- sowie Verarbeitungsquellen, z.B. SaaS-Dienste (Software-as-a-Service), Datenbanken, Dateifreigaben und FTP-Webdienste. Der nächste Schritt umfasst das Verschieben der Daten an einen zentralen Ort zur weiteren Verarbeitung. Ohne Data Factory müssen Unternehmen benutzerdefinierte Komponenten für die Datenverschiebung erstellen oder benutzerdefinierte Dienste schreiben, um diese Datenquellen und die Verarbeitung zu integrieren. Das Integrieren bzw. Verwalten dieser Systeme ist teuer und aufwändig. Häufig fehlen für Unternehmen geeignete Überwachungs- , Warnfunktionen sowie die Steuerungsmöglichkeiten eines vollständig verwalteten Diensts.

Mit Data Factory können Sie die Kopieraktivität in einer Datenpipeline nutzen, um Daten sowohl aus lokalen als auch aus cloudbasierten Quelldatenspeichern zur weiteren Analyse in einen zentralen Datenspeicher in der Cloud zu verschieben. Beispielsweise können Sie Daten in Azure Data Lake Storage sammeln und später transformieren, indem Sie einen Azure Data Lake Analytics-Computedienst verwenden. Außerdem können Sie Daten in Azure Blob Storage sammeln und später per Azure HDInsight Hadoop-Cluster transformieren.

Transformieren / Erweitern

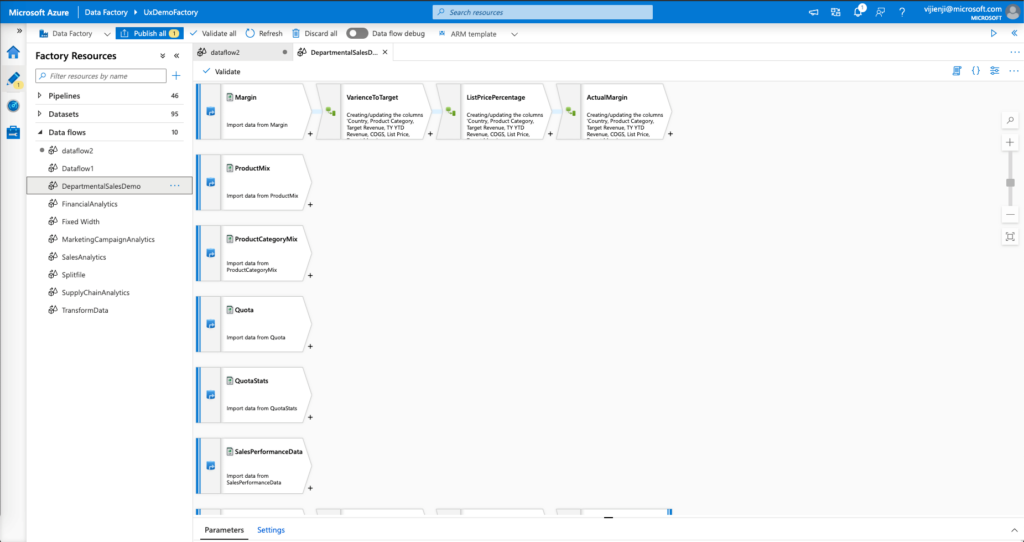

Wenn Daten in einem zentralisierten Datenspeicher in der Cloud vorliegen, können Sie die gesammelten Daten mit ADF-Zuordnungsdatenflüssen verarbeiten oder transformieren. Mit Datenflüssen können Datentechniker Graphen für die Datentransformation erstellen sowie verwalten, die unter Spark ausgeführt werden, ohne mit Spark-Clustern oder der Spark-Programmierung vertraut sein zu müssen.

Falls Sie das manuelle Codieren von Transformationen vorziehen: ADF unterstützt externe Aktivitäten zur Ausführung Ihrer Transformationen mit Computediensten, z. B. HDInsight Hadoop, Spark, Data Lake Analytics, Machine Learning.

CI/CD und Veröffentlichung

Data Factory verfügt über vollständige Unterstützung von CI/CD für Ihre Datenpipelines per Azure DevOps und GitHub. Dies ermöglicht Ihnen das inkrementelle Entwickeln und Bereitstellen Ihrer ETL-Prozesse vor der Veröffentlichung des fertigen Produkts. Nachdem die Rohdaten in einem für Unternehmen nutzbaren Format vorliegen, laden Sie sie mit Azure Data Warehouse, Azure SQL-Datenbank, Azure CosmosDB oder einer anderen Analyse-Engine, auf die Ihre Benutzer*innen in ihren Business Intelligence-Tools verweisen können.

Überwachen

Nachdem Sie Ihre Pipeline für die Datenintegration erfolgreich erstellt und bereitgestellt haben um einen geschäftlichen Nutzen aus den optimierten Daten zu ziehen, können Sie die geplanten Aktivitäten als auch Pipelines auf Erfolgs- und Fehlerraten überwachen. Azure Data Factory bietet integrierte Unterstützung für die Pipelineüberwachung per Azure Monitor, API, PowerShell, Azure Monitor-Protokolle und Integritätsbereiche im Azure-Portal.

Allgemeine Konzepte

Ein Azure-Abonnement kann über mindestens eine Azure Data Factory-Instanz (bzw. Data Factory) verfügen. Azure Data Factory besteht aus den folgenden Hauptkomponenten:

- Pipelines

- Aktivitäten

- Datasets

- Verknüpfte Dienste

- Datenflüsse

- Integration Runtimes

Zusammen stellen sie die Plattform dar, auf der Sie datengesteuerte Workflows mit Schritten zum Verschieben sowie Transformieren von Daten zusammenstellen können.